Databricks 新开源模型 DBRX

Databricks 最近发布了新的强大开源模型 DBRX。该模型架构如下:

- 拥有 132B 参数的 MoE 模型,共有 16 个专家。

- 每个 Token 激活 4 个专家,总共有 36B 的活跃参数。

- 相比于 Mixtral 的 13B 活跃参数,DBRX 少了近3倍。

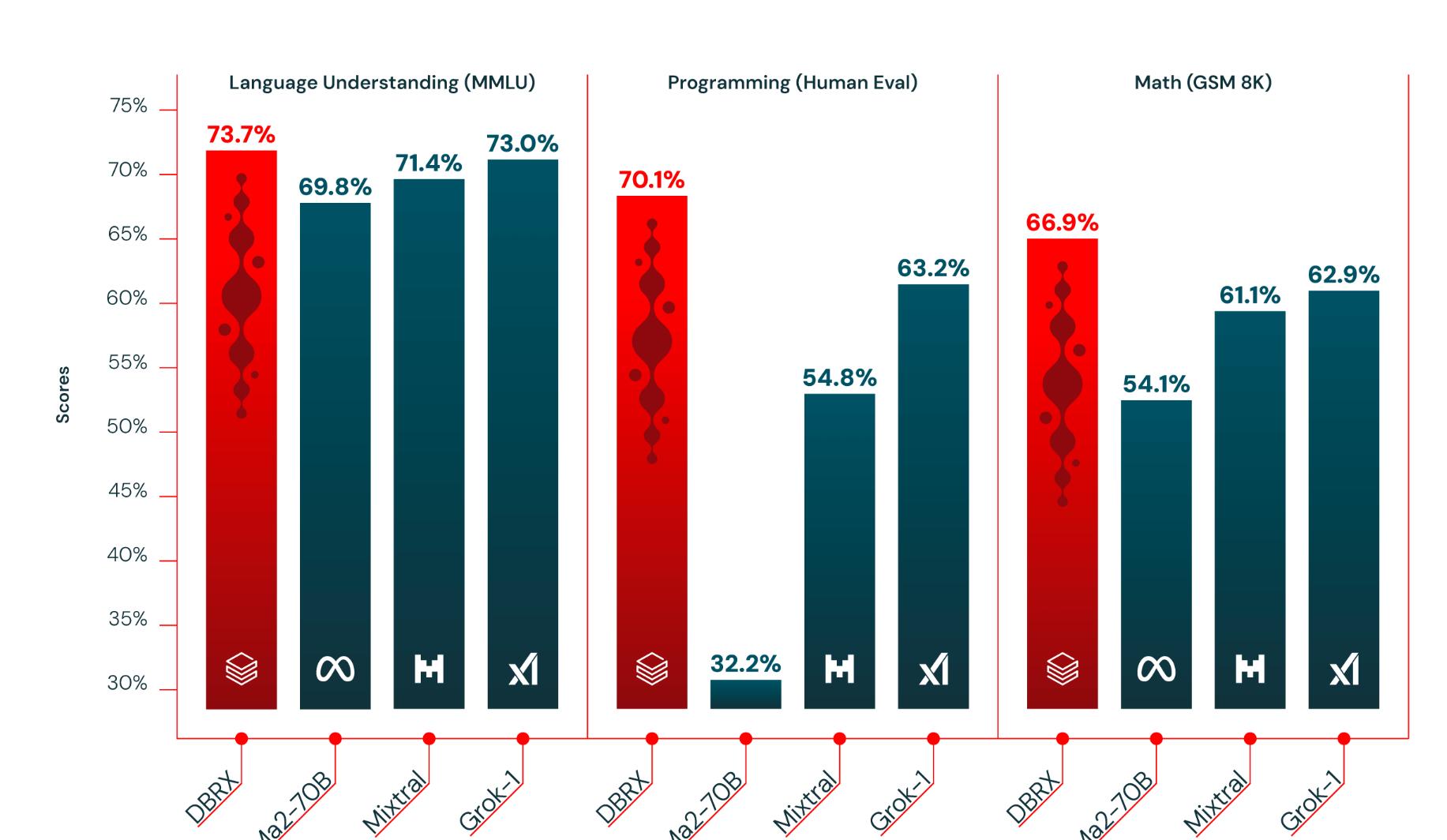

性能表现:

- 在语言理解、编程、数学和逻辑方面,DBRX 轻松击败了开源模型,如 LLaMA2-70B、Mixtral 和 Grok-1。

- 在大多数基准测试中,DBRX 超过了 GPT-3.5。

DBRX 是基于 MegaBlocks 研究和开源项目构建的专家混合模型(MoE),使得该模型在每秒处理的标记数量方面非常快速。

数据训练:

- 以 12 万亿 Token 的文本和代码进行预训练。

- 支持的最大上下文长度为 32k Tokens。

更多信息: 点击查看

@Databricks @DBRX @MoE